HBase笔记:对HBase原理的简单理解

早些时候学习hadoop的技术,我一直对里面两项技术倍感困惑,一个是zookeeper,一个就是Hbase了。现在有机会专职做大数据相关的项目,终于看到了HBase实战的项目,也因此有机会搞懂Hbase原理。

首先来点实在的东西,假如我们已经在服务器上部署好了Hbase应用,作为客户端或者说的具体点,本地开发环境如何编写程序和服务端的Hbase进行交互了?

下面我将展示这些,首先看工程的结构图,如下图所示:

接下来我们将hbase应用下lib文件夹里所有jar包都导入到工程lib目录下,还要把conf目录下的hbase-site.xml下载下来放置在conf目录里,这里我还将hbase项目里的log4j.properties文件放置到了项目的根目录下,这样在我们运行程序时候,控制台打印的日志也会更加的详细,下面是HBaseStudy.java的源代码:

package cn.com.hbasetest;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;<br/>

import org.apache.hadoop.hbase.HBaseConfiguration;<br/>

import org.apache.hadoop.hbase.HColumnDescriptor;<br/>

import org.apache.hadoop.hbase.HTableDescriptor;<br/>

import org.apache.hadoop.hbase.MasterNotRunningException;<br/>

import org.apache.hadoop.hbase.TableName;<br/>

import org.apache.hadoop.hbase.ZooKeeperConnectionException;<br/>

import org.apache.hadoop.hbase.client.Get;<br/>

import org.apache.hadoop.hbase.client.HBaseAdmin;<br/>

import org.apache.hadoop.hbase.client.HTable;<br/>

import org.apache.hadoop.hbase.client.Put;<br/>

import org.apache.hadoop.hbase.client.Result;<br/>

import org.apache.hadoop.hbase.client.ResultScanner;<br/>

import org.apache.hadoop.hbase.client.Scan;<br/>

import org.apache.hadoop.hbase.util.Bytes;<br/>

import org.slf4j.Logger;<br/>

import org.slf4j.LoggerFactory;

public class HBaseStudy {

public final static Logger logger = LoggerFactory.getLogger(HBaseStudy.class);

/* 构建Configuration,这里就是hbase-site.xml解析出来的对象,这里我还指定了本地读取文件的方式 */<br/>

static Configuration hbaseConf = HBaseConfiguration.create();<br/>

static {<br/>

hbaseConf.addResource("conf/hbase-site.xml");<br/>

}

/**<br/>

* 插入数据<br/>

* @throws IOException<br/>

*/<br/>

public void putTableData() throws IOException {<br/>

HTable tbl = new HTable(hbaseConf, "xsharptable001");<br/>

Put put = new Put(Bytes.toBytes("xrow01"));<br/>

put.add(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol01"), Bytes.toBytes("xvalue01"));<br/>

put.addColumn(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"), Bytes.toBytes("xvalue02"));<br/>

put.addImmutable(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol03"), Bytes.toBytes("xvalue03"));

tbl.put(put);<br/>

}

/**<br/>

* 插入多行数据<br/>

* @throws IOException<br/>

*/<br/>

public void putTableDataRow() throws IOException {<br/>

HTable tbl = new HTable(hbaseConf, "xsharptable001");<br/>

Put put = new Put(Bytes.toBytes("xrow02"));<br/>

put.add(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol01"), Bytes.toBytes("xvalue012"));<br/>

put.addColumn(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"), Bytes.toBytes("xvalue022"));<br/>

put.addImmutable(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"), Bytes.toBytes("xvalue032"));

tbl.put(put);

put = new Put(Bytes.toBytes("xrow03"));<br/>

put.add(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol01"), Bytes.toBytes("xvalue0213"));<br/>

put.addColumn(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"), Bytes.toBytes("xvalue0123"));<br/>

put.addImmutable(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol03"), Bytes.toBytes("xvalue0223"));

tbl.put(put);

put = new Put(Bytes.toBytes("xrow04"));<br/>

put.add(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol01"), Bytes.toBytes("xvalue0334"));<br/>

put.addColumn(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"), Bytes.toBytes("xvalue0224"));<br/>

put.addImmutable(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol03"), Bytes.toBytes("xvalue0334"));<br/>

put.addImmutable(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol04"), Bytes.toBytes("xvalue0334"));<br/>

tbl.put(put);<br/>

}

/**<br/>

* 查询hbase表里的数据<br/>

* @throws IOException<br/>

*/<br/>

public void getTableData() throws IOException {<br/>

HTable table = new HTable(hbaseConf, "xsharptable001");<br/>

Get get = new Get(Bytes.toBytes("xrow01"));<br/>

get.addFamily(Bytes.toBytes("xcolfam01"));<br/>

Result result = table.get(get);<br/>

byte[] bs = result.getValue(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"));<br/>

// ============查询结果:xvalue02<br/>

logger.info("============查询结果:" + Bytes.toString(bs));

}

/**<br/>

* 创建hbase的表<br/>

*<br/>

* @throws MasterNotRunningException<br/>

* @throws ZooKeeperConnectionException<br/>

* @throws IOException<br/>

*/<br/>

public void createTable() throws MasterNotRunningException, ZooKeeperConnectionException, IOException {<br/>

HBaseAdmin admin = new HBaseAdmin(hbaseConf);<br/>

if (admin.tableExists(Bytes.toBytes("xsharptable001"))) {<br/>

logger.info("===============:表已经存在!failure!");<br/>

} else {<br/>

TableName tableName = TableName.valueOf(Bytes.toBytes("xsharptable001"));<br/>

HTableDescriptor tableDesc = new HTableDescriptor(tableName);<br/>

HColumnDescriptor hcol = new HColumnDescriptor(Bytes.toBytes("xcolfam01"));<br/>

tableDesc.addFamily(hcol);<br/>

admin.createTable(tableDesc);<br/>

logger.info("==============:表创建成功了!Success!");<br/>

}<br/>

}

/**<br/>

* 通过scan扫描数据,相当于关系数据的游标<br/>

*<br/>

* @throws IOException<br/>

*/<br/>

public void scanTableData() throws IOException {<br/>

HTable tbl = new HTable(hbaseConf, "xsharptable001");<br/>

Scan scanAll = new Scan();<br/>

ResultScanner scannerAll = tbl.getScanner(scanAll);<br/>

for (Result resAll : scannerAll) {<br/>

/*<br/>

* 打印出来的结果: 2016-06-14 15:46:10,723 INFO [main]<br/>

* hbasetest.HBaseStudy: ======ScanAll<br/>

* :keyvalues={xrow01/xcolfam01:xcol01/1465885252556/Put<br/>

* /vlen=8/seqid=0,<br/>

* xrow01/xcolfam01:xcol02/1465885252556/Put/vlen=8/seqid=0,<br/>

* xrow01/xcolfam01:xcol03/1465885252556/Put/vlen=8/seqid=0}<br/>

* 2016-06-14 15:46:10,723 INFO [main] hbasetest.HBaseStudy:<br/>

* ======ScanAll<br/>

* :keyvalues={xrow02/xcolfam01:xcol01/1465887392414/Put<br/>

* /vlen=9/seqid=0,<br/>

* xrow02/xcolfam01:xcol02/1465887392414/Put/vlen=9/seqid=0}<br/>

* 2016-06-14 15:46:10,723 INFO [main] hbasetest.HBaseStudy:<br/>

* ======ScanAll<br/>

* :keyvalues={xrow03/xcolfam01:xcol01/1465887392428/Put<br/>

* /vlen=10/seqid=0,<br/>

* xrow03/xcolfam01:xcol02/1465887392428/Put/vlen=10/seqid=0,<br/>

* xrow03/xcolfam01:xcol03/1465887392428/Put/vlen=10/seqid=0}<br/>

* 2016-06-14 15:46:10,723 INFO [main] hbasetest.HBaseStudy:<br/>

* ======ScanAll<br/>

* :keyvalues={xrow04/xcolfam01:xcol01/1465887392432/Put<br/>

* /vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol02/1465887392432/Put/vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol03/1465887392432/Put/vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol04/1465887392432/Put/vlen=10/seqid=0}<br/>

*/<br/>

logger.info("======ScanAll:" + resAll);<br/>

}<br/>

scannerAll.close();

Scan scanColFam = new Scan();<br/>

scanColFam.addFamily(Bytes.toBytes("xcolfam01"));<br/>

ResultScanner scannerColFam = tbl.getScanner(scanColFam);<br/>

for (Result resColFam : scannerColFam) {<br/>

/*<br/>

* 2016-06-14 15:50:54,690 INFO [main] hbasetest.HBaseStudy:<br/>

* ======scannerColFam<br/>

* :keyvalues={xrow01/xcolfam01:xcol01/1465885252556<br/>

* /Put/vlen=8/seqid=0,<br/>

* xrow01/xcolfam01:xcol02/1465885252556/Put/vlen=8/seqid=0,<br/>

* xrow01/xcolfam01:xcol03/1465885252556/Put/vlen=8/seqid=0}<br/>

* 2016-06-14 15:50:54,690 INFO [main] hbasetest.HBaseStudy:<br/>

* ======scannerColFam<br/>

* :keyvalues={xrow02/xcolfam01:xcol01/1465887392414<br/>

* /Put/vlen=9/seqid=0,<br/>

* xrow02/xcolfam01:xcol02/1465887392414/Put/vlen=9/seqid=0}<br/>

* 2016-06-14 15:50:54,690 INFO [main] hbasetest.HBaseStudy:<br/>

* ======scannerColFam<br/>

* :keyvalues={xrow03/xcolfam01:xcol01/1465887392428<br/>

* /Put/vlen=10/seqid=0,<br/>

* xrow03/xcolfam01:xcol02/1465887392428/Put/vlen=10/seqid=0,<br/>

* xrow03/xcolfam01:xcol03/1465887392428/Put/vlen=10/seqid=0}<br/>

* 2016-06-14 15:50:54,690 INFO [main] hbasetest.HBaseStudy:<br/>

* ======scannerColFam<br/>

* :keyvalues={xrow04/xcolfam01:xcol01/1465887392432<br/>

* /Put/vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol02/1465887392432/Put/vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol03/1465887392432/Put/vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol04/1465887392432/Put/vlen=10/seqid=0}<br/>

*/<br/>

logger.info("======scannerColFam:" + resColFam);<br/>

}<br/>

scannerColFam.close();

Scan scanRow = new Scan();<br/>

scanRow.addColumn(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol02"))<br/>

.addColumn(Bytes.toBytes("xcolfam01"), Bytes.toBytes("xcol04")).setStartRow(Bytes.toBytes("xrow03"))<br/>

.setStopRow(Bytes.toBytes("xrow05"));<br/>

ResultScanner scannerRow = tbl.getScanner(scanRow);<br/>

for (Result resRow : scannerRow) {<br/>

/*<br/>

* 2016-06-14 15:57:29,449 INFO [main] hbasetest.HBaseStudy:<br/>

* ======scannerRow<br/>

* :keyvalues={xrow03/xcolfam01:xcol02/1465887392428/<br/>

* Put/vlen=10/seqid=0} 2016-06-14 15:57:29,449 INFO [main]<br/>

* hbasetest.HBaseStudy:<br/>

* ======scannerRow:keyvalues={xrow04/xcolfam01<br/>

* :xcol02/1465887392432/Put/vlen=10/seqid=0,<br/>

* xrow04/xcolfam01:xcol04/1465887392432/Put/vlen=10/seqid=0}<br/>

*/<br/>

logger.info("======scannerRow:" + resRow);<br/>

}<br/>

scannerRow.close();<br/>

}

public static void main(String[] args) {<br/>

HBaseStudy hb = new HBaseStudy();<br/>

/*try {<br/>

hb.createTable();<br/>

hb.putTableData();<br/>

} catch (Exception e) {<br/>

e.printStackTrace();<br/>

}*/

try {<br/>

// hb.getTableData();<br/>

// hb.putTableDataRow();<br/>

hb.scanTableData();<br/>

} catch (Exception e) {<br/>

e.printStackTrace();<br/>

}<br/>

}<br/>

}

这段代码写得匆忙,示例并没有好好设计,不过代码我是测试过,完全可以正常运行,下面几站截图是我通过hbase shell查询测试结果,如下图所示:

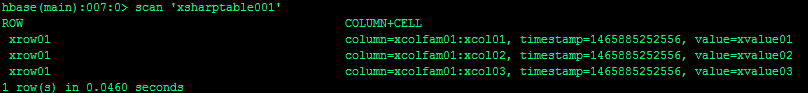

图一:

这里我通过describe命令查看表的基本信息。

图二:

这里我使用scan命令进行全表扫描。

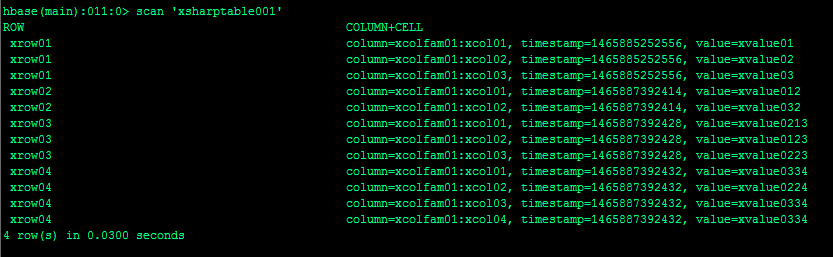

图三:

当我插入更多数据时候使用scan命令进行全表扫描。

本篇文章不会着重讲解hbase的javaAPI,其实本实例里也只是使用了少量的API,不过在我选择的API里我想体现的是hbase里表(table),行(rowkey),列族(family)和列(column)之间的关系。

创建表我们要先定义好表名,列族,插入数据我们首先是插入行,然后根据列族定义列接下来添加数据,这些都是按照hbase设计规范进行操作的,下面就是关键所在了:我们是如何查询数据的。

对于查询的Get操作,我们构造Get对象时候就是使用rowkey进行,scan可以进行全表扫描,也可以根据列族查询,还可以使用rowkey的范围限定scan扫描数据的范围,不管从什么角度进行查询,我们可以总结出hbase做查询时候都会跟rowkey和列族相关,hbase的javaAPI并没有再去提供更多查询手段,因此我们可以得出在提升hbase查询效率的因素里rowkey和列族必然承担了很重要的作用。

大数据时代的数据量是超大规模的,传统的关系数据库已经很难存储和管理这些数据了,为了存储海量数据,我们有了HDFS,它可以把成千上万台服务器上的硬盘聚集成一块超级大的硬盘,为了让这些数据产生价值,我们有了mapreduce,它可以计算这个超大硬盘的数据,面对这么大的数据量我们还有一个迫切的需求那就是如何快速检索出我们想要的数据,而这个功能就是由hbase来承担。

那么如此海量数据快速检索技术原理又是怎样的呢?我觉得原理很简单就是索引技术。Hbase通过rowkey来区别不同类型数据,通过列族把经常需要一起被查询出来的数据放在一起,例如我们如果要做一个电商平台的交易记录业务表设计,对于电商平台下的商户他其实只需要查询出自己的交易信息,而不会去关心其他商户的交易信息,那么我们就可以把商户号作为rowkey,每一个商户的交易的信息我们就放在一个列族里,商户号这样的信息就像数据在硬盘上的门牌号,我们一传入这个值做查询,hbase就能快速找到数据存储的位置,这就是hbase能快速检索到数据的原理。

上面讲到的原理只是业务抽象的角度来说,在hbase底层它就是根据上面说到的这些原理来设计的,hbase里面有region的概念,region是一个数据集合,那么什么样的数据会放置到某一个region里呢?hbase是根据rowkey来把同一类的数据放置在一个region里,rowkey下面就是列族,列族对应的底层存储就是hfile,hfile放置在rowkey对应的region下,所以当我们查询时候我们很容易通过业务规则找到我们设计好的rowkey,找到了rowkey就找到region,那么region下存储的hfile列族信息也就可以全部查询出来了。

Rowkey其实就是hbase的索引,也可以说是hbase官方给出的唯一索引,因此很多资料里说hbase只有一级索引,这个一级索引就指的就是rowkey,因此如何设计rowkey就是一门大学问了,时常我们一行数据不能满足我们复杂的查询要求,我们需要跨行就像scan那么扫描多行数据,而region里的行都是按照一定顺序排列的,这个顺序就是字典顺序,这个我在以前一篇文章里提到过,所以碰到这种情况,我们一般会通过md5将key散列,这样相邻的数据行会排列在一起,底层存储数据时候也会存储在同一个地方(相同region)或者是相互靠近的地方(相邻region),这样也就可以提升查询的效率。

Hbase内部有两张表一个是-ROOT-表和.META.表,客户端程序就是像我上面给出的示例程序首先访问zookeeper,通过zookeeper获取含有-ROOT-的region服务器名,通过-ROOT-的region服务器可以查询到.META.表里行键rowkey对应的region位置,而-ROOT-和.META.客户端访问后就会缓存起来。

其实hbase的表设计本身非常简单,对外接口也没有关系数据库那么丰富,我最近学习hbase,觉得hbase基本都没有关系数据库里那些计算函数,可见hbase只是提供一种能快速检索海量数据的一种计算模型而已。

转发申明:

本文转自互联网,由小站整理并发布,在于分享相关技术和知识。版权归原作者所有,如有侵权,请联系本站 top8488@163.com,将在24小时内删除。谢谢